È ormai allarme per i video deepfake: i filmati online contraffatti, in cui attraverso fotomontaggi perfetti, personaggi celebri vengono infangati in porno video e cose del genere.

Twitter annuncia adesso che in futuro potrebbe avvertire gli utenti se stanno guardando o condividendo video, audio o foto manipolati. Ad esempio i cosiddetti deepfakes. Tuttavia Twitter non li rimuoverà. La proposta è contenuta in una bozza di policy pubblicata dal social media sul proprio blog.

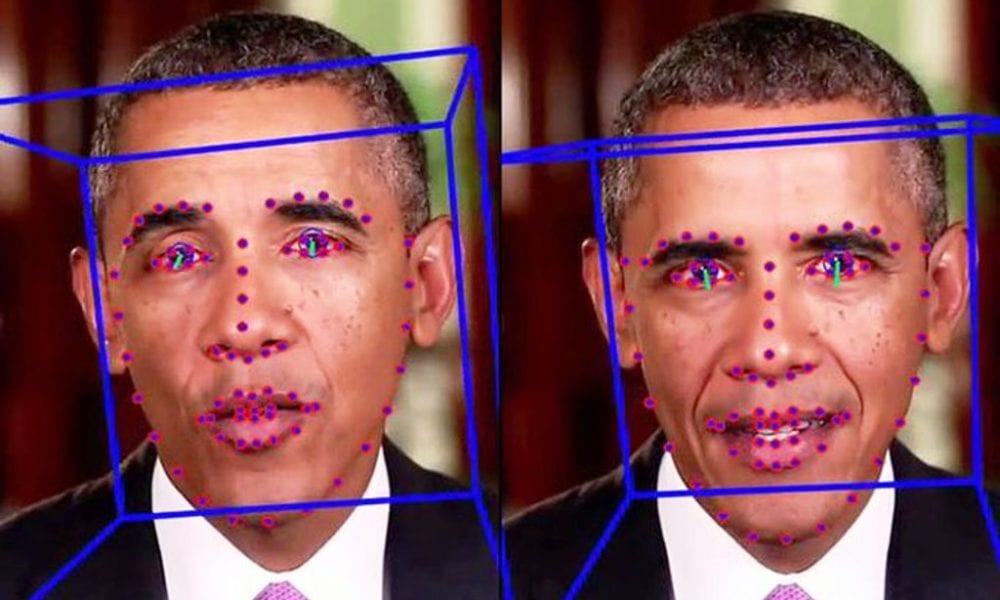

I video falsi deepfake sono resi indistinguibili dagli originali grazie all’intelligenza artificiale. Sono considerati un pericolo ad esempio se utilizzati per diffondere false informazioni sui politici in prossimità di elezioni. Il 98% di quelli censiti in rete, ha scoperto uno studio pubblicato recentemente, riguarda finora soprattutto donne inserite in video pornografici.

Le regole proposte da Twitter, che ha lasciato fino al 27 novembre la possibilità di commento agli utenti, prevedono che il social inserisca una nota ai tweet che contengono deepfake. In modo tale che avvertano gli utenti prima che lo condividano. I video sarebbero rimossi soltanto se considerati minacciosi per l’incolumità fisica di qualcuno o se possono portare a “danni gravi”.

“Se si rivolge a Twitter per capire cosa succede nel mondo – si legge nel post – vogliamo che l’utente abbia un’idea del contesto del contenuto che sta vedendo. Tentativi deliberati di fuorviare o confondere le persone con media manipolati mettono a rischio l’integrità della conversazione”.